Google a publié son rapport annuel sur la sécurité des annonces pour 2024, mettant en avant l’utilisation accrue de modèles de langage de grande taille (LLMs) pour lutter contre les publicités frauduleuses et trompeuses. Voici les points clés de cette initiative.

Utilisation des LLMs pour améliorer la sécurité des annonces

Google a déployé plus de 50 LLMs améliorés pour renforcer l’application de sa politique publicitaire. Ces modèles d’IA, qui nécessitent moins de données pour prendre des décisions, ont permis de traiter plus efficacement les tactiques de fraude en constante évolution.

Résultats de l’initiative

- Suspension de comptes : En 2024, Google a suspendu 39,2 millions de comptes publicitaires aux États-Unis pour des activités frauduleuses, soit plus de trois fois plus qu’en 2023 (12,7 millions).

- Motifs de suspension : Les suspensions sont principalement dues à des abus du réseau publicitaire, une utilisation inappropriée des données de personnalisation, des allégations médicales fausses, des violations de marques déposées, ou une combinaison de ces infractions.

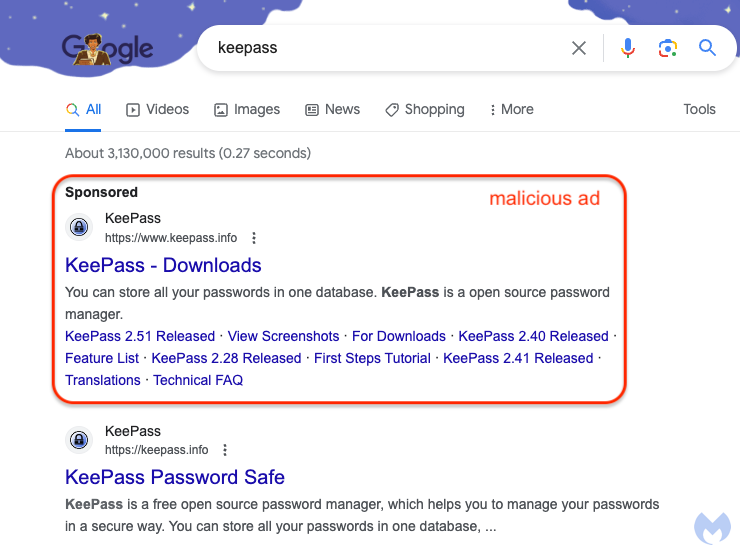

- Réduction des publicités malveillantes : Google a identifié et supprimé 1,8 milliard de publicités malveillantes aux États-Unis et 5,1 milliards dans le monde. Bien que ce chiffre soit légèrement inférieur aux 5,5 milliards de publicités supprimées en 2023, cela suggère que Google a réussi à stopper les comptes frauduleux avant qu’ils ne puissent diffuser des publicités.

Lutte contre les mauvais usages de l’IA dans les publicités

Google a également pris des mesures pour contrer l’utilisation malveillante de l’IA dans les publicités :

- Mise à jour de la politique de fausse représentation : Une équipe de 100 experts a été constituée pour mettre à jour la politique de Google, ce qui a permis d’identifier et de bloquer 700 000 comptes d’annonceurs, entraînant une réduction de 90 % des arnaques utilisant des deepfakes.

- Blocage de pages : Google a bloqué 1,3 milliard de pages de la diffusion d’annonces, principalement en raison de contenus sexuels, dangereux ou dérogatoires, ainsi que de logiciels malveillants.

Google exploite l’IA pour la cybersécurité

Bien que les LLMs aient considérablement amélioré la détection des publicités malveillantes, ils ne sont pas infaillibles. Google reconnaît que des erreurs peuvent survenir, entraînant la suspension incorrecte de comptes. Cependant, l’entreprise affirme que des humains sont toujours impliqués dans le processus de vérification, bien que le volume d’annonces rende impossible une vérification manuelle complète.

Ces efforts montrent l’engagement de Google à utiliser l’IA pour améliorer la sécurité et la qualité des publicités en ligne, tout en reconnaissant les défis persistants.