Le H100 NVL représente le meilleur atout de la gamme Hopper de NVIDIA. Il s’agit d’une variante de l’accélérateur de centre de données H100 conçue dans un seul but : stimuler les modèles de langage d’IA, tels que Chat-GPT.

En bref, NVL signifie NVLink, qui est utilisé par cette configuration sur le GPU H100. Le H100 NVL n’est pas un GPU mais une option dual-GPU de deux cartes PCIe connectées l’une à l’autre via trois ponts NVLink Gen4.

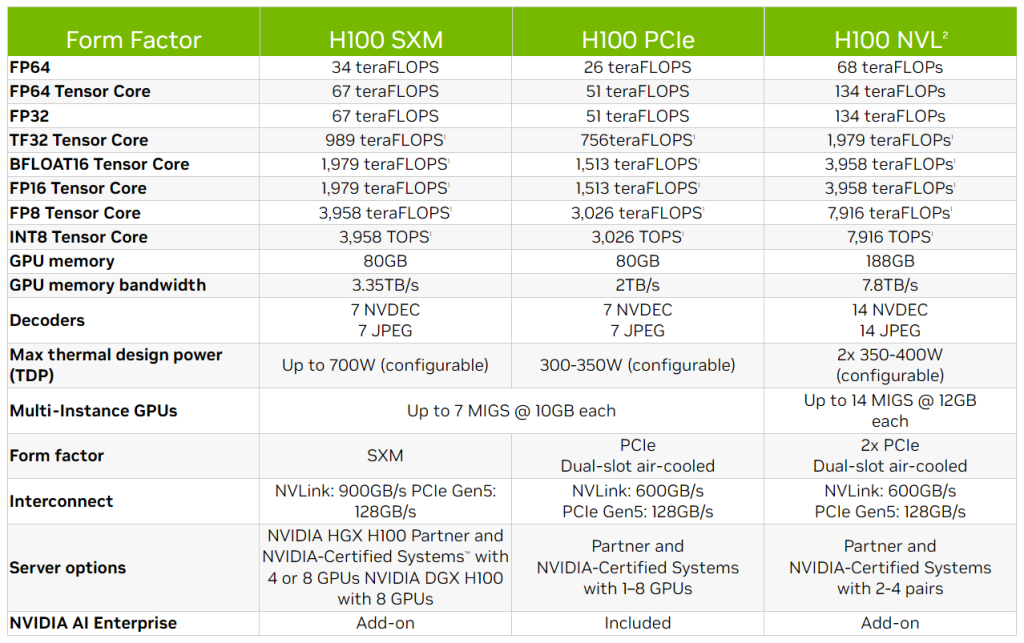

En revanche, la variante NVL possède un avantage supplémentaire par rapport aux GPU H100 existants en termes de capacité de mémoire. Grâce à l’utilisation de six piles de mémoire HBM3, ce GPU offre une mémoire totale de 188 Go. Cette capacité exceptionnelle implique que chaque GPU dispose de seulement 94 Go disponibles, au lieu de 96 Go.

Avec une interface mémoire complète de 6144 bits (soit 1024 bits pour chaque pile de mémoire HBM3) et une vitesse de mémoire allant jusqu’à 5,1 Gbps, le NVL H100 est capable d’un débit maximal de 7,8 Go/s, soit plus de deux fois supérieur au H100 SXM. Cette bande passante plus élevée aura sans aucun doute un impact significatif sur les modèles de langue qui nécessitent de grandes mémoires tampons.

La NVIDIA H100 NVL est idéale pour le déploiement de grands modèles de langage à grande échelle des LLM comme ChatGPT. La nouvelle NVL H100 avec 94 Go de mémoire et l’accélération Transformer Engine offre des performances d’inférence jusqu’à 12 fois plus rapides à GPT-3 par rapport à la génération précédente A100 à l’échelle d’un centre de données.

NVIDIA prévoit de lancer le GPU H100 NVL au cours du second semestre de cette année, sans donner plus de détails.