Apple a présenté aujourd’hui en avant-première de nouvelles fonctionnalités d’accessibilité qui apparaîtront dans iOS 17. Avec Assistive Access, les applications personnalisées Téléphone, FaceTime, Messages, Appareil photo, Photos et Musique sont regroupées dans une seule application Appels.

Pour les utilisateurs d’iPhone qui préfèrent communiquer visuellement, l’application Messages comprend un clavier QWERTY réservé aux émojis et la possibilité d’enregistrer un message vidéo à envoyer à ses proches.

Assistive Access permettra aux utilisateurs de choisir entre une disposition de leur écran d’accueil en grille, plus visuelle ou une disposition en ligne.

L’accès assisté facilite l’utilisation de l’iPhone pour les personnes souffrant de troubles cognitifs.

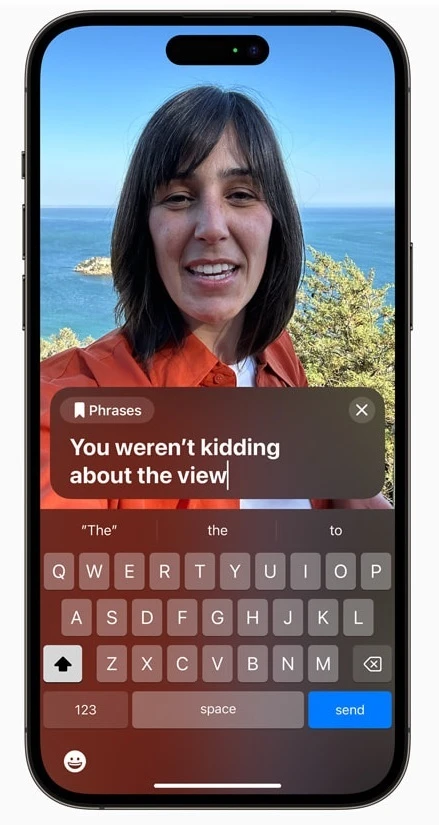

Avec Live Speech, qui sera disponible sur iPhone, iPad et Mac, pendant les appels téléphoniques et FaceTime, un utilisateur peut taper ce qu’il veut dire et le faire prononcer à haute voix par son appareil, de sorte que les autres participants à l’appel vocal ou vidéo puissent l’entendre. Les phrases souvent répétées par l’utilisateur peuvent être enregistrées et insérées rapidement dans les conversations avec les amis, la famille et les collègues. Apple souligne que Live Speech est « conçu pour aider des millions de personnes dans le monde qui ne peuvent pas parler ou qui ont perdu la parole avec le temps ».

Pour les personnes qui risquent de perdre leur voix, une fonctionnalité appelée Personal Voice leur permettra de lire un texte aléatoire pendant environ 15 minutes sur un iPhone ou un iPad. Cette fonction s’intègre à la fonction Live Speech mentionnée plus haut, de sorte qu’un utilisateur d’iPhone ou d’iPad qui a perdu sa voix peut toujours parler avec d’autres personnes en utilisant une version enregistrée de sa voix.

Personal Voice permet à un utilisateur d’iPhone d’enregistrer des textes et des phrases sur l’appareil pour les utiliser avec la fonction Live Speech.

Une autre fonction d’accessibilité appelée « Point and Speak in Magnifier » aide les personnes souffrant d’un handicap visuel à lire les textes des icônes. Grâce à la caméra arrière, au scanner LiDAR et à l’apprentissage automatique de l’appareil, l’utilisateur peut pointer la caméra de son iPhone sur le panneau de commande d’un four à micro-ondes, par exemple, et lorsque l’utilisateur passe ses doigts sur l’image d’un bouton, l’iPhone annonce le texte associé à ce bouton. Cela permettra aux personnes qui ne voient pas bien de garder le contrôle sur certaines parties de leur vie.

Il s’agit là de fonctionnalités utiles dont nous pourrions entendre parler davantage lorsqu’Apple présentera iOS 17 en avant-première lors de la conférence WWDC du 5 juin.

Tim Cook, PDG d’Apple, a déclaré : « Chez Apple, nous avons toujours pensé que la meilleure technologie est celle qui est conçue pour tout le monde. Aujourd’hui, nous sommes ravis de partager d’incroyables nouvelles fonctionnalités qui s’appuient sur notre longue histoire pour rendre la technologie accessible, afin que chacun ait la possibilité de créer, de communiquer et de faire ce qu’il aime. »